致力打造国内好用的AI产品导航平台

LM Studio是一个易于使用的桌面应用程序,用于试验本地和开源的大型语言模型(llm)。LM Studio跨平台桌面应用程序允许您从hugs Face下载并运行任何与ggml兼容的模型,并提供简单而强大的模型配置和推理UI。该应用程序在可能的情况下利用你的GPU。

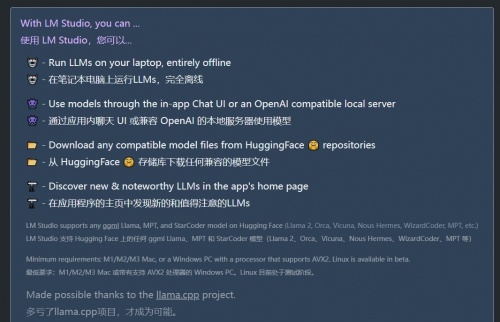

功能集:提供更广泛的功能集,包括发现、下载和运行本地 LLM,以及应用内聊天界面以及与 OpenAI 兼容的本地服务器接口。

UI 友好性:与 Ollama 相比,被认为对用户界面更加友好。

模型选择:提供来自 Hugging Face 等更广泛的模型选择。

支持的操作系统:适用于 M1/M2/M3 Mac 或具有支持 AVX2 处理器的 Windows PC,Linux 已推出测试版。

LM Studio 的亮点功能

模型的多样性与灵活性,借助 LM Studio,你可以轻松获取和管理当今最受欢迎的各种大型语言模型,包括:

Llama 3 :Meta 出品,拥有更强的性能与可靠性,是对话生成任务的绝佳选择。

Phi 3 :Phi 根据大量自然语言和编程数据训练而成,致力于适用于多样化的语言生成任务。

Falcon :以高性能和快速响应为亮点,适合需要快速生成的应用场景。

Mistral :强大的多任务型语言模型,支持多种语言理解与生成任务。

StarCoder :特别设计用于编程任务的模型,代码生成、补全的得力助手。

Gemma :适用于翻译、对话生成等用途的通用型大型语言模型。

这些模型能够满足多样需求,为 AI 应用开发提供了坚实的基础支持。除此之外,用户可以下载、安装并运行各种基于 Hugging Face 的模型,无需编写代码即可在本地测试模型性能。无论你的项目需求变化多大,LM Studio 都能提供给你最广泛的模型选择。

高效、快速、安全的离线运行

LM Studio 最大的亮点之一在于其针对本地运行的优化。

是的,你无需依赖云端即可体验高效的模型生成。无论是生产环境还是开发测试场景,这为对隐私、安全和速度有高要求的组织和开发者带来了莫大的便捷。

简洁友好的用户界面

运行 LLM 模型可不只针对技术人员。LM Studio 通过直观的图形用户界面 (GUI),让用户可以一目了然地下载和管理模型。

下载模型文件仅需点击几下,你甚至可以在应用内创建定制化提示,以更好地与模型互动,降低了上手难度。

几乎不需要任何技术背景,你便能够上手下载、配置并运行你心仪的模型。

多样的硬件加速支持

LM Studio 的设计充分考虑了模型性能,它综合利用 GPU 和 CPU 的能力,确保模型在本地以最优效率运行。其多线程优化、硬件加速等多项优化措施,使模型在本地设备上也能够快速响应。

得益于对硬件加速的全面支持,无论是 NVIDIA GPU、Apple MPS,让高效运行成为你指尖的现实。

模型自动化管理

对于模型的更新和管理,LM Studio 同样提供了自动化功能。模型的下载、更新和相关环境配置全都可以由应用自动完成,让你无需为模型维护烦心,集中精力专注于开发。

优雅的多模型切换

不再担心在多个模型之间切换时的混乱。LM Studio 的界面使你可以轻松切换不同模型,并查看每个模型的详细信息和参数。这意味着,你可以方便地根据需求选择最适合的模型,而无需在文件夹里费力地查找。

持续更新

LM Studio 团队致力于保持其技术的领先地位。新模型的支持、新功能的迭代以及性能的优化等方面,团队都在不断努力,因此用户可以享受到最新和最强大的 LLM 技术。

沪公网安备31010602007845号

沪公网安备31010602007845号